Interpretación plurisensorial de imágenes y sonidos

Combinar información procedente de distintos sentidos ayuda a elegir y actuar de manera adecuada. Por ejemplo, «si algo es muy prominente en nuestra visión, no necesitaríamos el mecanismo plurisensorial para decidir si tomar medidas. Pero, si caminamos por el bosque al anochecer, un leve aullido puede ayudar a percibir un perro apenas visible entre la niebla. En tal contexto, vincular ambas informaciones será crucial para decidir si debemos actuar», señala Manuel Mercier, coordinador del proyecto financiado con fondos europeos MIMe.

De individual a plurimodal

Financiado por el programa Marie Skłodowska-Curie, en MIMe se estudió esta compleja interacción entre los sentidos y la toma de decisiones. La toma de decisiones perceptivas, el proceso que guía nuestro comportamiento, se puede dividir en una fase de codificación sensorial (donde una señal sensorial se codifica en la corteza sensorial relacionada) y una fase de adopción de decisiones. «Nuestro objetivo fue averiguar si las señales sensoriales procedentes de diferentes sentidos están interrelacionadas desde el momento en que llegan al encéfalo, es decir, en la fase de codificación o durante la fase de adopción de decisiones. Además, nos propusimos identificar los mecanismos neuronales y la arquitectura subyacente a la convergencia plurisensorial», explica Mercier.

Una orquesta de oscilaciones encefálicas

Nuevos hallazgos destacados apuntan a que la transferencia de información en los circuitos encefálicos se basa en oscilaciones neuronales(se abrirá en una nueva ventana) que reflejan variaciones en la actividad neuronal. Cuando dos grupos de neuronas oscilan en fase, es más probable que intercambien información. Aún es necesario investigar más a fondo estos resultados, pero por el momento arrojan luz sobre un posible mecanismo neuronal del que se puede servir el encéfalo para asociar información sensorial y crear construcciones plurimodales. «MIMe estudió si la asociación plurimodal se basa en la sincronización de fase entre nodos de redes neuronales distantes», agrega Mercier.

Dar forma a lo que escuchamos

Para lograr sus objetivos, los investigadores del proyecto realizaron primero un estudio con pacientes con electrodos intracraneales implantados con fines clínicos. La atención se centró en registrar oscilaciones neuronales intracraneales mientras los participantes estaban expuestos a contornos ilusorios acompañados de un sonido. Cabe destacar que los investigadores observaron una gran sincronización en la actividad oscilatoria de las cortezas auditiva y visual. «Esta comunicación entre poblaciones neuronales distantes representa la codificación de un objeto plurimodal: las señales auditivas influyeron en lo que los pacientes pensaban que estaban viendo, es decir, la forma propuesta por los contornos ilusorios», señala Mercier.

La omnipresencia encefálica de la integración plurisensorial

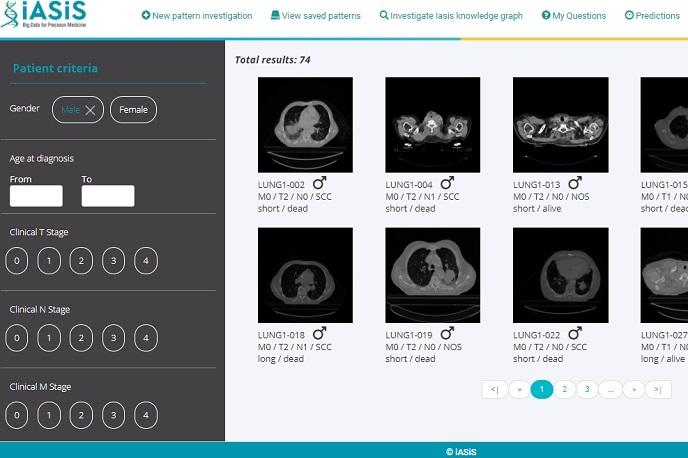

En otro estudio, los investigadores del proyecto expusieron a participantes sanos a una secuencia dinámica de señales visuales y sonoras para examinar cómo realizan cálculos complejos y reaccionan a combinaciones particulares de señales. Tras emplear métodos de aprendizaje automático programados para analizar la actividad eléctrica encefálica, los investigadores informaron de que la integración plurisensorial(se abrirá en una nueva ventana) aceleró la dinámica encefálica en la fase de codificación sensorial y durante la fase en la que los participantes decidieron su respuesta. Desde MIMe indicaron que la integración plurisensorial es omnipresente en el encéfalo humano y ejecuta varios procesos en la cadena de jerarquía de procesamiento. «La comprensión exhaustiva de la dinámica neuronal que tiene lugar entre los sentidos durante la adopción de una decisión aclarará las dificultades a las que se enfrenta parte de la población, como las personas con rasgos del espectro autista», concluye Mercier.